robots.txt 파일은 검색 엔진 크롤러가 웹사이트 내 어떤 페이지를 크롤링할지 또는 크롤링하지 말아야 할지를 지정하는 텍스트 파일로, SEO 최적화에 중요한 역할을 합니다. 이를 통해 불필요한 페이지의 크롤링을 차단하여 크롤링 예산을 효율적으로 사용하고, 서버 부하를 줄이며, 검색 엔진이 중요한 페이지를 빠르게 인덱싱하도록 도울 수 있습니다.

robots.txt를 활용한 SEO 최적화 전략은 다음과 같습니다:

- 불필요한 페이지 차단: 관리자 페이지, 로그인 페이지, 중복 콘텐츠 페이지 등 검색 결과에 노출될 필요 없는 페이지를 Disallow 지시어로 차단해 크롤링 예산을 절약합니다.

- 사이트맵 위치 명시: robots.txt 파일에 Sitemap 경로를 명시하여 검색 엔진에 사이트맵 위치를 알려줌으로써 크롤링 효율과 인덱싱 속도를 높입니다.

- 와일드카드 활용: 특정 패턴의 URL을 한 번에 차단하거나 허용할 때 와일드카드를 사용해 관리 편의성을 높입니다.

- Allow와 Disallow 조합: 특정 디렉토리 내 일부 페이지만 크롤링 허용하는 등 세밀한 제어가 가능합니다.

- robots.txt와 noindex 태그 병행 사용 주의: robots.txt로 크롤링을 차단하면 검색 엔진이 페이지를 방문하지 못해 noindex 태그가 적용되지 않을 수 있으므로, 인덱스 제외가 필요하면 크롤링은 허용하고 noindex 태그를 사용하는 것이 효과적입니다.

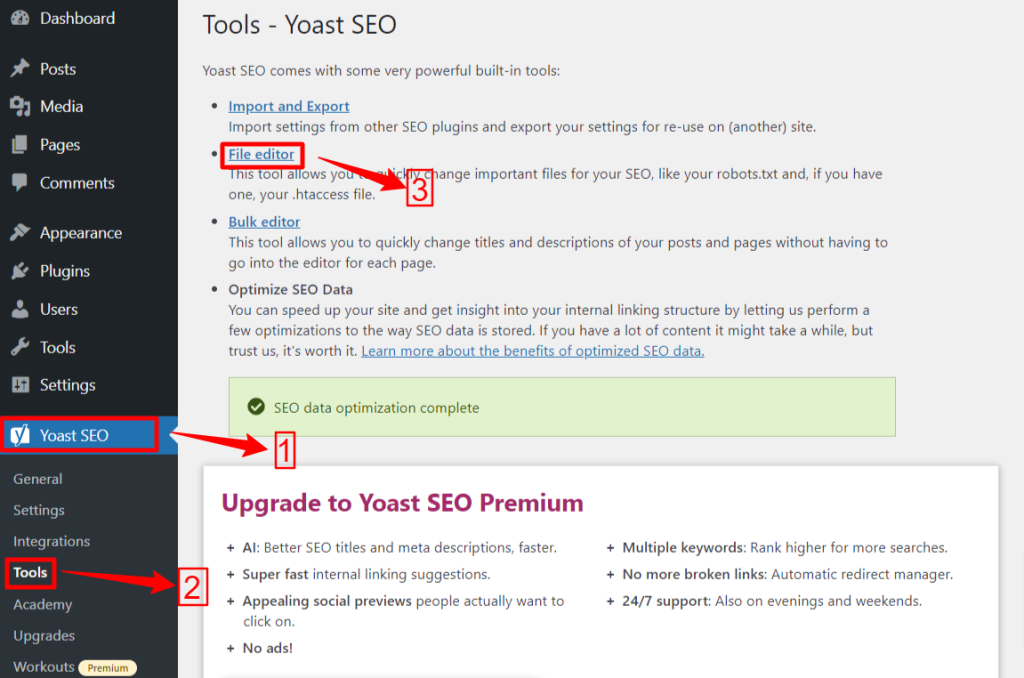

실제 사례로는 WordPress 사이트에서 플러그인 페이지나 시스템 파일을 robots.txt로 차단해 불필요한 크롤링을 막고, 사이트맵 링크를 추가해 검색 엔진이 주요 콘텐츠를 빠르게 인덱싱하도록 한 경우가 있습니다. 또한, Google Search Console에서 robots.txt 설정 오류를 점검하고 수정하여 '색인이 생성되었으나 robots.txt에 의해 차단됨' 경고를 해결하는 사례도 있습니다.

요약하면, robots.txt 파일을 통해 크롤링 대상과 제외 대상을 명확히 지정하고, 사이트맵 위치를 알리는 것은 SEO 최적화에 필수적인 전략이며, 이를 통해 검색 엔진의 크롤링 효율을 높이고 서버 자원 낭비를 줄일 수 있습니다. 다만, 인덱싱 제어가 필요할 때는 noindex 태그와의 조합을 신중히 고려해야 합니다.

Korea Traffic는 싱가포르에서 최고의 웹사이트 트래픽 서비스를 제공합니다. 우리는 웹사이트 트래픽, 데스크탑 트래픽, 모바일 트래픽, 구글 트래픽, 검색 트래픽, 전자상거래 트래픽, 유튜브 트래픽, 틱톡 트래픽 등 다양한 트래픽 서비스를 고객에게 제공합니다. 저희 웹사이트는 100% 고객 만족률을 자랑하므로, 대량의 SEO 트래픽을 온라인으로 자신 있게 구매하실 수 있습니다. 월 49,500 KRW만으로 즉시 웹사이트 트래픽을 증가시키고, SEO 성과를 개선하며, 매출을 증대시킬 수 있습니다!

트래픽 패키지 선택에 어려움이 있으신가요? 저희에게 연락주시면, 직원이 도움을 드리겠습니다.

무료 상담