한국 시장에서 robots.txt 파일은 검색엔진 최적화(SEO)와 서버 효율성 관리에 매우 전략적인 가치를 지닙니다. 주요 활용 가치는 다음과 같습니다.

-

크롤링 과부하 방지: 검색엔진 크롤러가 불필요한 페이지를 과도하게 크롤링하는 것을 막아 서버 부하를 줄이고 안정적인 사이트 운영을 돕습니다. 이는 서버 리소스 절약과 사이트 속도 유지에 중요합니다.

-

크롤 버짓(크롤링 예산) 최적화: 검색엔진이 하루에 크롤링할 수 있는 요청 수가 제한적이므로, 중요하지 않은 페이지를 robots.txt로 차단해 중요한 페이지가 더 빠르고 효율적으로 인덱싱되도록 합니다.

-

중복 콘텐츠 및 민감 정보 보호: 동적 URL이나 중복된 콘텐츠, 관리자 페이지 등 검색에 노출되면 안 되는 영역을 차단하여 SEO 순위 하락을 방지하고 개인정보 노출 위험을 줄입니다.

-

대역폭 및 서버 자원 절감: 크롤러가 불필요한 영역을 탐색하지 않도록 하여 대역폭 사용량과 서버 부하를 줄이고, 웹사이트 전반의 성능 향상에 기여합니다.

-

검색엔진별 규칙 준수: 네이버, 구글 등 주요 검색엔진이 robots.txt 규칙을 준수하므로, 이를 활용해 각 검색엔진에 맞는 크롤링 정책을 설정할 수 있습니다. 다만, 민감 정보는 로그인 차단 등 추가 보안 조치가 필요합니다.

robots.txt 활용 팁

-

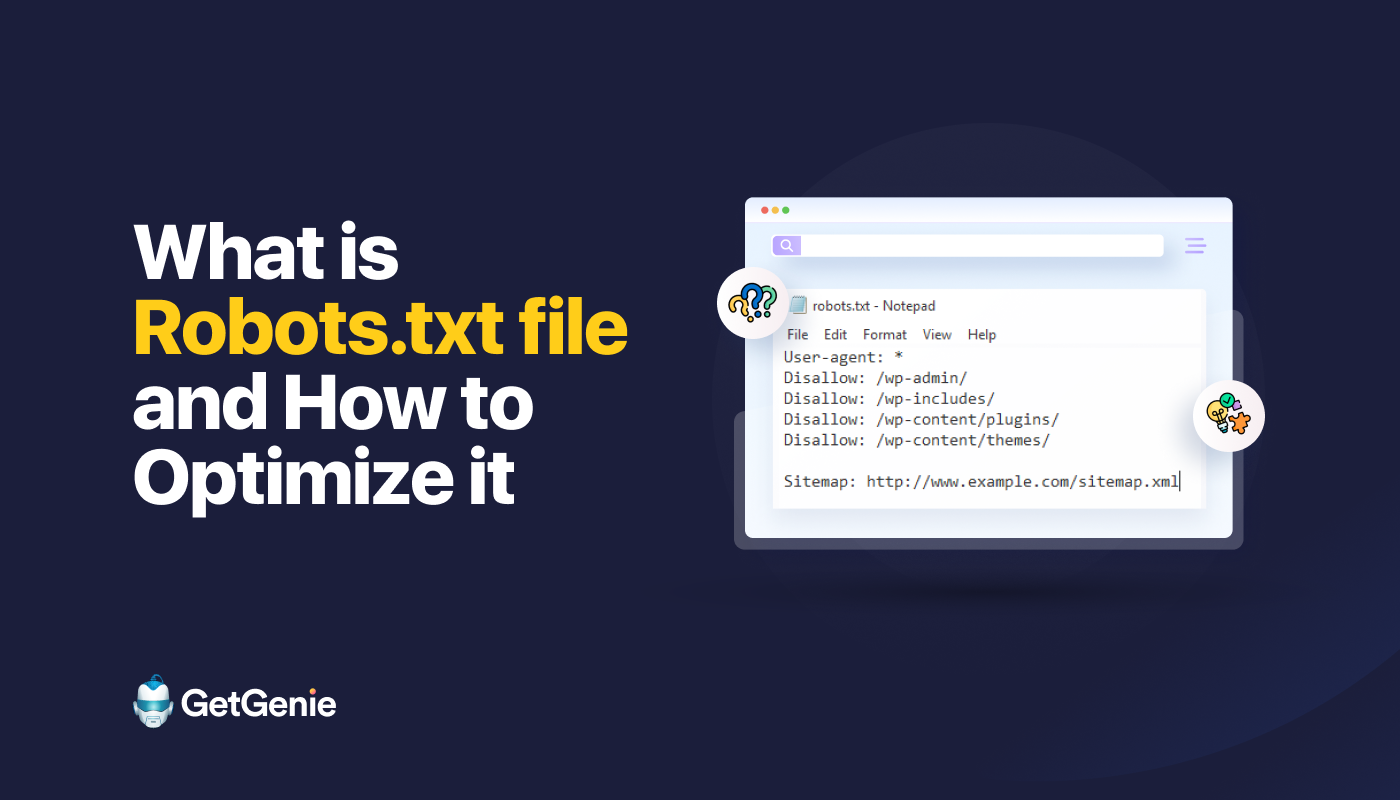

루트 디렉터리에 위치: robots.txt 파일은 반드시 사이트 루트(예: example.com/robots.txt)에 위치해야 하며, 텍스트 파일 형식이어야 합니다.

-

중요하지 않은 URL 패턴 차단: 동적 URL이나 파라미터가 포함된 페이지, 관리자 페이지, 플러그인 페이지 등은

Disallow지시문으로 크롤링을 제한합니다. 예를 들어,Disallow: /products?id=와 같이 설정할 수 있습니다. -

정규 표현식 활용: 일부 검색엔진은 정규 표현식을 지원하므로, 특정 패턴을 가진 URL을 세밀하게 차단할 수 있습니다.

-

크롤러별 세분화 설정: 특정 검색엔진 크롤러만 차단하거나 허용하는 규칙을 설정해 맞춤형 크롤링 정책을 운영할 수 있습니다.

-

서버 상태 점검: robots.txt가 정상적으로 작동하지 않으면 크롤링 오류가 발생할 수 있으므로, 서버 로딩 상태와 설정을 주기적으로 점검해야 합니다.

이처럼 robots.txt는 검색엔진 크롤링을 효율적으로 관리하여 SEO 성과를 높이고, 서버 안정성을 확보하는 데 필수적인 도구입니다.

Korea Traffic는 싱가포르에서 최고의 웹사이트 트래픽 서비스를 제공합니다. 우리는 웹사이트 트래픽, 데스크탑 트래픽, 모바일 트래픽, 구글 트래픽, 검색 트래픽, 전자상거래 트래픽, 유튜브 트래픽, 틱톡 트래픽 등 다양한 트래픽 서비스를 고객에게 제공합니다. 저희 웹사이트는 100% 고객 만족률을 자랑하므로, 대량의 SEO 트래픽을 온라인으로 자신 있게 구매하실 수 있습니다. 월 49,500 KRW만으로 즉시 웹사이트 트래픽을 증가시키고, SEO 성과를 개선하며, 매출을 증대시킬 수 있습니다!

트래픽 패키지 선택에 어려움이 있으신가요? 저희에게 연락주시면, 직원이 도움을 드리겠습니다.

무료 상담